Vergangenen Sonntag sorgte eine Vorabmeldung von Spiegel Online für einige Aufmerksamkeit: Sie wies auf einen Artikel im neuen Print-Spiegel hin und behauptete gewohnt reißerisch, die Bahn wolle Kundendaten verkaufen (die Bahn dementierte). De facto, so sezierte es dann Malte Spitz, der sich sowohl den Print-Spiegelartikel angesehen hatte als auch das Kleingedruckte bei der Bahn, hatte SpOn den Text nicht richtig wiedergegeben. Es ging vielmehr darum, dass die Bahn bestimmte AGB geändert hat, um konzernintern die BahnBonus-Daten weitergeben zu können; also das Reiseverhalten derjenigen, die an dem Bonusprogramm teilnehmen, effektiver auswerten zu können, um die jeweiligen Kunden passgenauer mit Werbung zu beschicken (Targeting).

Vergangenen Sonntag sorgte eine Vorabmeldung von Spiegel Online für einige Aufmerksamkeit: Sie wies auf einen Artikel im neuen Print-Spiegel hin und behauptete gewohnt reißerisch, die Bahn wolle Kundendaten verkaufen (die Bahn dementierte). De facto, so sezierte es dann Malte Spitz, der sich sowohl den Print-Spiegelartikel angesehen hatte als auch das Kleingedruckte bei der Bahn, hatte SpOn den Text nicht richtig wiedergegeben. Es ging vielmehr darum, dass die Bahn bestimmte AGB geändert hat, um konzernintern die BahnBonus-Daten weitergeben zu können; also das Reiseverhalten derjenigen, die an dem Bonusprogramm teilnehmen, effektiver auswerten zu können, um die jeweiligen Kunden passgenauer mit Werbung zu beschicken (Targeting).

Hätte nun ein Medium eine Datenjournalismus-Taskforce, was wäre möglich gewesen? Die Geschichte kam am Sonntagmorgen um 8 Uhr auf. Ein Newswebsite, die am Montagvormittag eine Datengeschichte dazu gebracht hätte, hätte sicherlich Aufmerksamkeit auf sich gezogen.

Was hätte ein Datenteam also machen können?

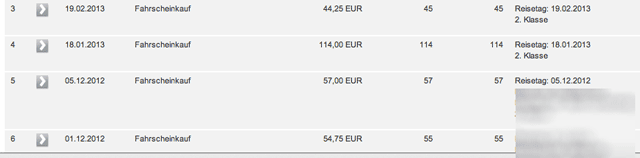

Es hätte zeigen können, was für Auswertungen anhand der Daten denn möglich wären. Ich kann über mein Bahnkonto bis zu 39 Monate meiner Verbindungen abrufen. In meinem Fall sind das 115 Fahrten, bei denen ich Punkte gesammelt habe. Diese Daten dürften mindestens 80 Prozent meiner Fahrten im Bahnfernverkehr in den letzten drei Jahren und drei Monaten abdecken. Neben dem Datum des Kaufs und dem Kaufpreis sind das Abfahrtsdatum und -ort sowie der Ankunftsort genannt (das eventuelle Rückreisedatum ist nicht dokumentiert). Die Daten selbst sind einfach aus der Website zu extrahieren. Sie stehen in einer HTML-Tabelle, die sich per Copy&Paste in ein Tabellenkalkulationsprogramm bringen lässt. Einzig die Verbindungendaten, also Abfahrts- und Zielort, müssten mit etwas RegEx o.ä. aufgesplittet werden.

Ein Nutzungsmuster über die Zeit und/oder eine Kartendarstellung (Heatmap) wäre recht einfach zu realisieren: Das Tool müsste ermöglichen, dass Leute ihre jeweilige Verbindungstabelle in ein Eingabefeld kopieren können und dann eine Auswertung gezeigt bekommen. Als zweiter Schritt wäre eine Crowdsourcing-Komponente drin gewesen: Eine Sammlung von anonymisierten Verbindungsprofilen, die mit der wachsenden Menge von Daten Muster deutlicher machen würde: Gibt es Ähnlichkeiten beim Bahnverhalten; spielen Jahreszeiten eine Rolle; wie sieht das Verhältnis zwischen Kurz-, Mittel- und Langstrecken aus. Welche Verbindung sind beliebt. Etc.

Pi mal Daumen wären für eine reine Profilvisualisierung 15 Stunden Arbeit vonnöten gewesen. Ein Team von zwei Leuten hätte das an einem Tag realisieren können. Die Crowdsourcingkomponente mit Filter-/Analysemöglichkeiten wäre aufwendiger gewesen und hätte sicherlich noch einmal mindestens 20 Stunden Arbeit verlangt. Hätte aber auch die Option geboten, um die Geschichte einige Tage später weiterzuspielen. Nachhaltig wären beide Ansätze und würden auch nach dem Versiegen des Aufmerksamkeitsschubs auf längere Zeit hin funktionieren.

Und was hat das jetzt mit Journalismus zu tun? Ein Tool, wie eben skizziert, hätte verdeutlicht, was die Bahn eigentlich an Informationen aus diesen BahnBonus-Daten ziehen kann. Es wäre ein Erklärstück – nicht mehr oder weniger. Ergänzt mit einem Hintergrundtext und Interview, wäre das eine runde Geschichte gewesen.

Du meinst also, ein Verlag bezahlt einen Datenjournalisten, der erstens spontan und zweitens an einem Sonntag einen Scraper baut, Daten in ein Sheet überträgt, Schaubilder generiert und einen ansprechenden Text daraus strickt?

Pauschal würde ich mindestens 300 Euro dafür nehmen. Möglichkeiten gibt es, aber Geld muss es auch geben.